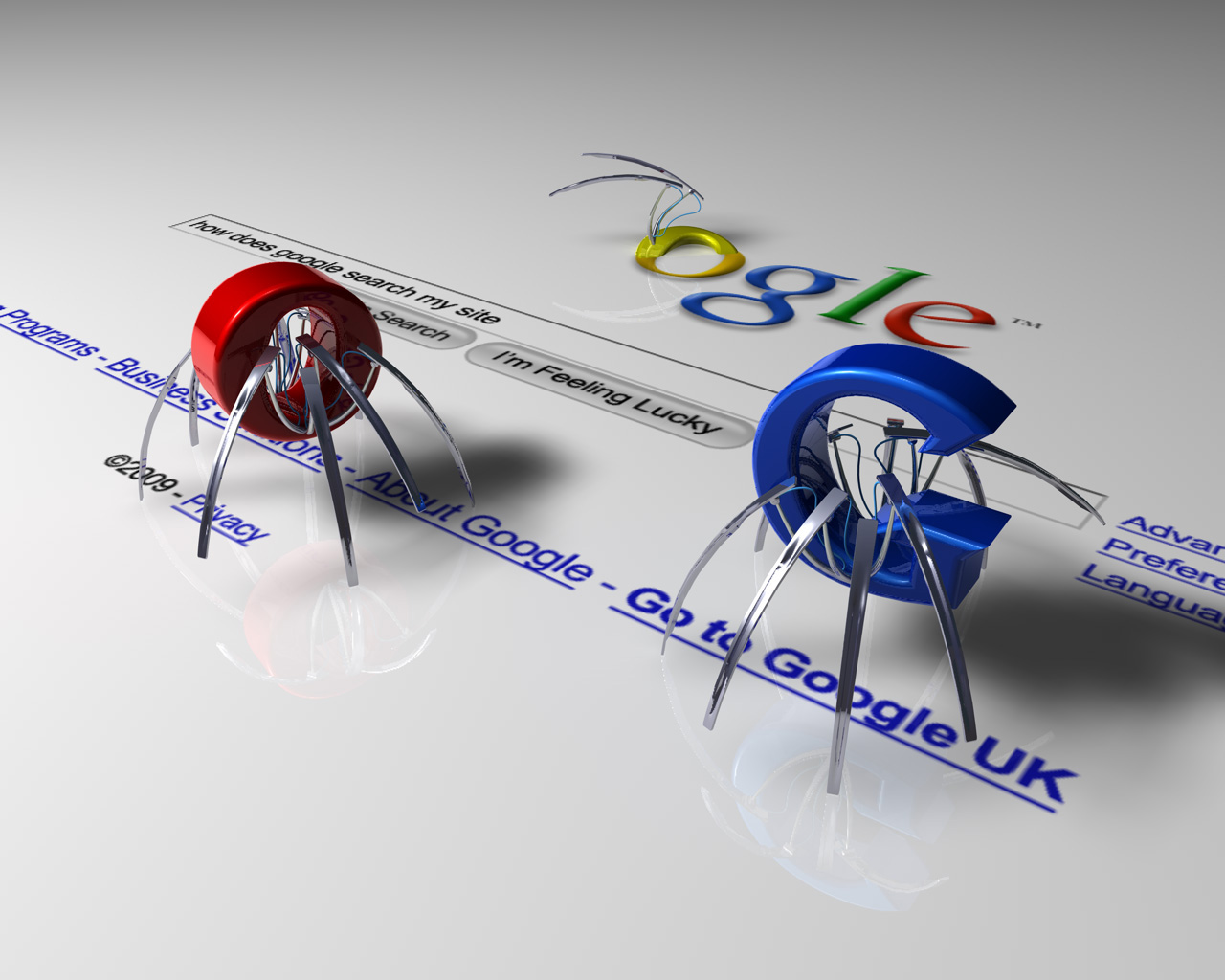

Google Spider là gì? Định nghĩa Google Spider.

Spider là gì hay Google Spider là gì nó chính là các “con bọ tìm kiếm “. Nó được tự động sinh ra từ các máy chủ của Google. Chúng có nhiệm vụ săn tìm, truy lùng các dữ liệu trên các website dựa trên các đường liên kết (link). Google spider hoạt động chủ yếu dựa vào liên kết ( link ) trên các pages, website và dựa vào hành vi người dùng hoặc truy vấn của trình duyệt tác động lên 1 page, website nào đó để lập chỉ mục cho page, website đó hiển thị trên công cụ tìm kiếm Google (index) và thời gian ở trong page, website của chúng là một khoảng thời gian nhất định! Các bạn cũng biết là thời gia tìm kiếm của google rất nhanh khi bạn tìm kiếm từ gì đó thì chỉ sau chưa đến 1s google đã trả về kết quả tìm kiếm cho bạn. Chứng tỏ các Spider hoạt động rất nhanh, nó lướt qua các site rất nhanh. Do đó để kéo giữ các Spider ở lại trên website của bạn càng lâu càng tốt. Video dưới đây sẽ cho bạn thấy nó hoạt động như thế nào?1. Phân loại Spider

Google spider được phân chia đơn giản hơn thành 2 loại : spider chủ động và spider thụ động.-

Spider chủ động

-

Spider thụ động

Google plus ( G+ ) khi người dùng click G+ để +1 cho page nào đó thì ngay lập tức Spider này sinh ra và đi tới page đó để tiến hành công việc. Để website được index nhanh, uy tín hơn thì các SEOER phải điều hướng được Spider để nó ghé thăm website của mình nhiều hơn. Vấn đề đặt ra là làm sao điều hướng được Spider.

Google plus ( G+ ) khi người dùng click G+ để +1 cho page nào đó thì ngay lập tức Spider này sinh ra và đi tới page đó để tiến hành công việc. Để website được index nhanh, uy tín hơn thì các SEOER phải điều hướng được Spider để nó ghé thăm website của mình nhiều hơn. Vấn đề đặt ra là làm sao điều hướng được Spider.

2. Cách điều hướng Spider

Cũng giống như con người, thường thì khi đọc văn bản chúng ta hay đọc từ trên xuống dưới, từ trái qua phải và Google Spider cũng đọc dữ liệu trên website của chúng ta như vậy. Do đó, thường những thông tin quan trọng chúng ta cần phải bố trí hợp lý với bố cục website để điều hướng Google Spider.- Điêu hướng 1: Đầu tiên khi vào Site của bạn nó sẽ tìm đến file: Robot.txt sau đó là file: Sitemap. Do đó trên mọi website 2 file này không được thiếu.

- Điều hướng thứ 2: Xấy dựng các liên kết nội bội để điều hướng Spide từ Pages này sang Pages khác trên cùng 1 website.

- Điều hướng thứ 3: Google spider tuân theo thuộc tính follow – nofollow hoặc index – noindex của thẻ meta hoặc thuộc tính disallow trong file robots.txt.Vì vậy khi xây dựng web các link không quan trọng, các bạn không muốn Spider chú ý tới thì các bạn hãy đặt thuộc tính “rel=’nofollow’ ” trong thẻ “<a rel=’nofollow’ href=””></a>” hoặc thuộc tính “noindex”. Các bạn cũng có thể sử dụng thuộc tính Disallow trong file Robot.txt để chặn các đường link xấu, các đường link không quan trọng.

>>> Xem thêm: Tổng hợp tài liệu học SEO

Chúc bạn thành công!